Pe plan mondial, Broadcom și CAMB.AI au anunțat o colaborare pentru dezvoltarea unui chipset capabil să traducă audio în timp real direct pe dispozitiv, fără a trimite datele în cloud. De la primele experimente de recunoaștere vocală și asistenți care înțelegeau doar câteva comenzi, până la telefoanele de azi și modelele lingvistice moderne, trecerea către procesare locală reflectă o tendință mai largă: edge AI care protejează confidențialitatea și reduce dependența de conexiune. Proiectul se aliniază eforturilor producătorilor de hardware de a integra inteligența artificială direct în cipuri, o transformare similară cu cea prin care acceleratoarele grafice au devenit componente uzuale în televizoare și console.

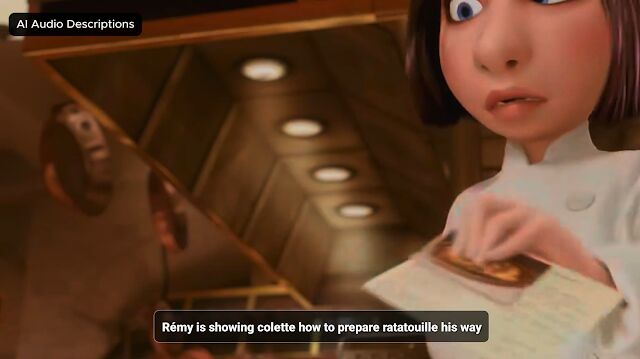

Conceptul e simplu, dar cu implicații majore: chipsetul combină modele pentru recunoașterea vorbirii, traducere și sinteză vocală care rulează integral pe NPU-ul Broadcom. Practic, un televizor sau un set-top-box ar putea asculta dialogul unui film și să redea instant traducerea în română, fie ca subtitrare, fie ca voce suprapusă, fără a trimite sunetul sau imaginile către servere externe. De asemenea, pe același dispozitiv se poate genera descrierea audio a ceea ce se întâmplă pe ecran pentru persoanele cu deficiențe de vedere, oferind accesibilitate oriunde, nu doar în aplicații dedicate. Demonstrația echipelor a folosit un fragment din filmul Ratatouille, unde AI-ul descrie acțiunea și afișează simultan traducerea, iar modelele CAMB.AI sunt deja folosite în medii precum NASCAR, Comcast sau Eurovision, ceea ce indică o aplicabilitate practică a tehnologiei.

Avantajele evidente includ reducerea dependenței de internet și latența mai mică pentru funcții sensibile la întârziere. Pentru cei care urmăresc conținut străin, înseamnă că traducerea în timp real nu va mai depinde de calitatea conexiunii sau de serverele unei companii. Totuși, rămân provocări tehnice: acuratețea traducerilor în fața accentelor, a zgomotului de fundal, a dialogurilor suprapuse sau a scenelor complexe trebuie testată în condiții reale. Broadcom nu a oferit un calendar precis pentru apariția primelor televizoare sau receptoare cu acest chipset, menționând doar că direcția este comercială și că producătorii interesați pot integra cipul în generațiile viitoare de hardware. În plus, colaborarea Broadcom cu OpenAI pentru cipuri dedicate AI sugerează o orientare a pieței hardware spre soluții specializate, iar integrarea modelelor lingvistice complete în SoC ar putea deveni la fel de comună pe termen lung precum sunt astăzi acceleratoarele grafice.

Demo-ul cu Ratatouille evidențiază cum un televizor ar putea descrie și traduce dialogul fără a trimite date în cloud. Această abordare ridică aspecte concrete legate de confidențialitate, accesibilitate și ergonomia consumului media, dar și întrebări practice despre adoptarea comercială și despre calitatea traducerilor în scenarii reale. Dacă producătorii vor integra rapid astfel de cipuri, s-ar putea schimba modul în care consumăm mii de canale și conținut străin; dacă nu, inițiative similare se vor difuza treptat. Crezi că aceste tehnologii vor ajunge curând în televizoarele din casele noastre sau vor rămâne mult timp doar în demonstrații și laboratoare?

Sursa text și foto: HD Satelit

Fii primul care comentează